Hey

多元线性回归问题

代价函数(整体数据集),损失函数(对于每个数据的误差)

learning_rate(从小的尝试比如0.0006)

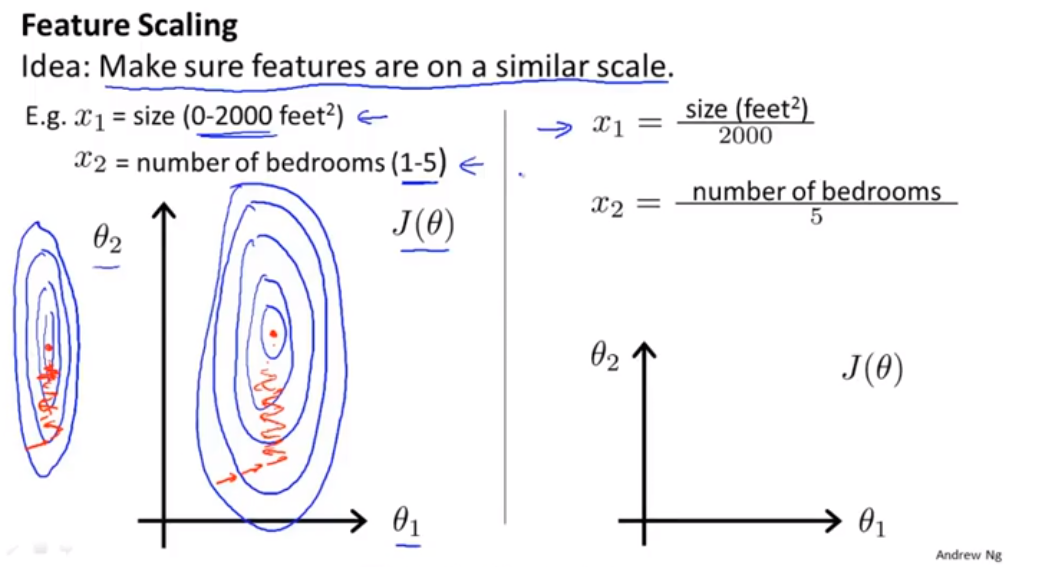

scaling the features(特征缩放)—适用与梯度下降改进 -Mean normalization(均值归一化)

1.min-max标准化

X(每个数据) - U(特征值均值))/(Max-Min)

2.Z-score标准化方法

X(每个数据) - U(特征值均值))/(std)

3.归一化

把数据变成(0,1)或者(1,1)之间的小数。主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速

normal equation(正规方程) or Gradient Descent

normal equation is suitable for samll features(计算量比较大)

Gradient descent is suitable for a large number for features(

)

)

但是受数据的影响较大,所以对与Gradient descent来说需要进行feature scaling)normalize equation(正规方程)的公式推导 代价函数

矩阵不可逆:

1.矩阵存在线性相关的特征之值

2.矩阵所对应的行列式为0